原始地址CountBayesie

本文是CountBayesie博客上Kullback-LeiblerDivergenceExplained文章的学习笔记。KL散度概念的原始解释非常清楚且易于理解。

相对熵,也称为KL散度(KullbackLeible散度),是描述两个概率分布P和Q之间的差异的一种方法。

这是不对称的,意味着D(P || Q)D(Q || P)。

KL散度计算

测量由近似分布引起的信息丢失。

散度KL的公式实际上是熵公式的简单变体。通过将近似概率分布q与原始概率分布p相加来计算每个值的对数差。

换句话说,KL散度计算数据的原始分布与近似分布的概率之间的对数差异的期望值。

是否要输入2的对数?

2.您可以看到丢失的信息已按预期写入。

查看KLdivergencewritingisa的一般方法如下:

使用KLdivergencia,您可以准确地计算出一种分布接近另一种分布时丢失了多少信息。

发散不是距离

发散KL不是可交换的,不能理解为距离的概念。它不是空间中两个分布之间的距离。为了更准确地理解,请测量一种分发与另一种分发相比的信息丢失(信息丢失)。

使用KL散度进行了优化

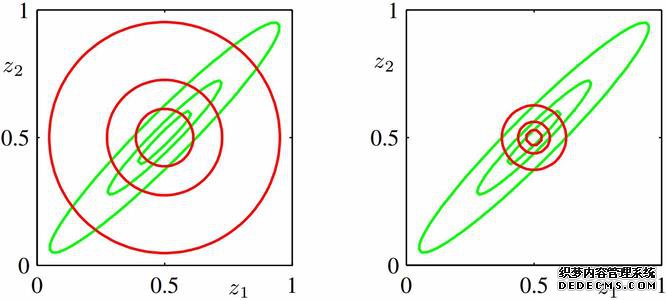

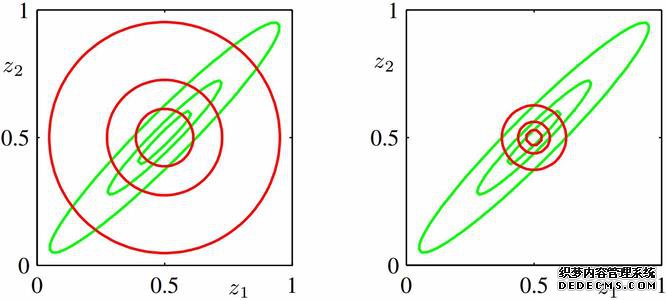

通过不断地改变估计分布的参数,可以获得不同的KL散度值。

在一定的变化范围内,当散度KL达到最小值时,相应的参数变为最佳参数。

这是使用不同KL的优化过程。

CodenameNC参考博客

GAN网络使用KL散度